Der KI-Verordnung enthält keine Definition, die erklärt, was ein KI-Modell i.S.d. EU AI Acts ist und welche Komponenten es besitzt. Trotz der Unbestimmtheit beinhaltet der EU AI Act eine Reihe von Vorgaben für unterschiedliche Varianten von KI-Modellen. Darunter solche mit allgemeinem Verwendungszweck und solche, die in Hochrisiko-KI-Systemen integriert sind. Wie kann die Definitionslücke gefüllt werden? Teil 1 von 3 einer Analyse mit Handlungsempfehlungen.

Link zu Teil 2/3 dieses Beitrags

- Im ersten von drei Teilen des Beitrags wird dargestellt, welche Auswirkungen das Fehlen einer Definition u.a. aus Sicht der KI-Forschung und KI-Praxis hat.

- Es wird ein 5-Layer-Modell vorgestellt, mit dem fachliche, technische, rechtliche und ethische Vorgaben strukturiert werden können.

- Zudem wird ein Blick auf bestehende Definitionen für KI-Modelle von internationalen KI-Organisationen sowie der OECD geworfen.

- Abschließend erfolgt die These, das die bevorstehende Entwicklung des Code of Practice für GPAI-Modelle das skizzierte Problem zeitnah lösen könnte.

Normen zu diesem Beitrag, u.a.:

- Artikel 3 EU AI Act

- Artikel 6 EU AI Act

- Artikel 15 EU AI Act

- Artikel 54 EU AI Act

- Artikel 56 EU AI Act

- Anhang III EU AI Act

Das KI-Modell i.S.d. EU AI Acts – Teil 1

Der EU AI Act differenziert zwischen KI-Systemen und KI-Modellen. KI-Modelle sind Assets von KI-Systemen. Dabei sind diverse Verschachtelungen möglich (vgl. u.a. Artikel 3 Nr. 63, 66 EU AI Act):

- Mehrere KI-Modelle in einem KI-System,

- ein KI-Modell in mehreren KI-Systemen und

- KI-Systeme als Bestandteil von anderen KI-Systemen.

So weit herrscht trügerische Klarheit.

Es mutet jedoch irritierend an, dass nur für KI-Systeme eine übergreifende Definition in Artikel 3 Nr. 1 EU AI Act veröffentlicht wurde. Eine entsprechende Definition für KI-Modelle fehlt.

Vorab sechs Beispiele zur Relevanz des definitorischen Vakuums:

- Die vier Risiko-Klassen des EU AI Acts gelten grundsätzlich nur für KI-Systeme. Nicht für die darin enthaltenen KI-Modelle. Gleichwohl gibt es „knackige“ Vorgaben für die i.d.R. recht spezifischen KI-Modelle von Hochrisiko-KI-Systemen (vgl. Artikel 15 (5) S.3 EU AI Act). Schon allein dafür sollte geklärt sein, was (ganz allgemein betrachtet) ein KI-Modell i.S.d. EU AI Acts ist und was nicht!

- Ähnlich ist es bei (freiwilligen) Verhaltenskodizes für KI-Systeme mittlerer und geringer Risiken. Entsprechende Kodizes sollten u.a. erklären können, weshalb das darin verwendete KI-Modell vertrauenswürdig ist. Dabei ist egal, ob es einen „allgemeinen Verwendungszweck“ besitzt oder nicht. Auch dafür ist eine grundlegende Definition für KI-Modelle sinnvoll.

- Kapitel V enthält schließlich umfassende Vorgaben für KI-Modelle „mit allgemeinem Verwendungszweck“. Innerhalb der Lieferkette ist es wiederum von Bedeutung, dass alle Beteiligten eine gemeinsame Vorstellung davon haben, was ein KI-Modell ausmacht: Wo es beginnt und wo es aufhört. Erneut würde eine klare Definition weiterhelfen!

- GPAI-Modelle mit freier quelloffener Lizenz, wie sie in Artikel 53 (2) und Artikel 54 (6) EU AI Act sowie Ziffer (102) der Erwägungsgründe beschrieben werden, benötigen ebenfalls klare Kriterien. Erst recht, weil diese KI-Modelle aufgrund von Open Source von nachgelagerten Akteuren modifiziert werden können: Doch wann erfolgt eine Änderung des GPAI-Modells, und wann handelt es sich um eine Änderung anderweitiger Komponenten und Assets eines KI-Systems?

- Im Hinblick auf die „nachgelagerte Anbieterschaft“ ist in Artikel 3 Nr. 68 EU AI Act ganz allgemein von „KI-Modellen“ die Rede. Die nachgelagerte Anbieterschaft entsteht also immer dann, wenn „irgendwelche“ KI-Modelle in „irgendwelche“ KI-Systeme integriert werden.

- Schließlich kann ein KI-System auch mehrere (modifizierte) KI-Modelle verwenden, was zu einem durchaus komplexen Zusammenspiel der einzelnen Modelle führen kann. Erst eine klare Definition für KI-Modelle aller Art macht es möglich, die Grenzen und Übergänge der einzelnen KI-Modelle zu bestimmen und dadurch den regulatorischen Überblick zu bewahren.

1. KI-Modell ohne „allgemeinen Verwendungszweck“ – was ist das?

Mal ehrlich: Welcher Anbieter eines beliebigen KI-Modells wird daran interessiert sein, dass sein „Produkt“ unter die umfangreichen Vorgaben von Kapitel V fällt?

- Doch woher wissen KI-Anbieter, Entwickler und Domain-Experten, ob und in welchem Umfang ihr „Produkt“ überhaupt als KI-Modell i.S.d. EU AI Acts anzusehen ist – beruht dies auf Selbsteinschätzung oder gibt es klare Kriterien?

- Was also ist mit den unzähligen KI-Modellen, denen der „allgemeine Verwendungszweck“ zu Beginn fehlt, sich dieser aber im Laufe der Zeit dazu entwickelt? Welche neuen Zwecke sind dabei relevant und welche nicht? Was ist mit Zwecken, die nicht intendiert sind, aber faktisch genutzt werden?

- Wie ist demzufolge die „Evolution“ eines KI-Modells zu dokumentieren? Welcher Teil der Dokumentation betrifft „nur“ das KI-Modell? Welche Dokumentation betrifft weitere Assets wie Daten oder Infrastruktur? Wo verlaufen die Grenzen?

Erst wenn diese und ähnliche Fragen geklärt sind, stellt sich überhaupt die Frage, wann es sich im Einzelfall um ein KI-Modell „mit allgemeinen Verwendungszweck“ handelt. Erst wenn diese Grundfrage geklärt ist, gilt es zu prüfen, ob auch „systemische Risiken“ i.S.v. Artikel 3 Nr. 65 EU AI Act vorliegen.

Bei all dem würde eine klare und übergreifende Definition für ein KI-Modell i.S.d. EU AI Act weiterhelfen. Doch diese Definition fehlt – zumindest bislang.

Artikel 3 Nr. 63 EU AI Act enthält zwar eine Definition für KI-Modelle mit allgemeinem Verwendungszweck. Offen bleibt jedoch, was überhaupt ein KI-Modell ist. Die „sonstigen“ KI-Modelle „ohne allgemeinen Verwendungszweck“ sind mit hoher Wahrscheinlichkeit die überwiegende Mehrheit aller existierenden KI-Modelle – doch welche Eigenschaften zeichnen sie aus? Welche nicht?

Das Fehlen der Definition wäre wohl weniger kritisch, wenn nicht auch für die „sonstigen“ KI-Modelle Vorgaben und Empfehlungen existieren würden. Zudem kann auch von kleineren KI-Modellen Risiken ausgehen, was ein klares und regulatorisch abgesichertes Verständnis gemeinsamer Kriterien für KI-Modelle jeglicher Art erforderlich macht.

2. High-Speed-Evolution von KI-Modellen

Hinzu kommt, dass die Innovation von KI-Modellen immer offenkundiger zum eigentlichen Treiber für die zunehmende Leistungsfähigkeit von KI-Systemen wird. Sie ist der Turbo der Anwendungen, in die sie eingebettet sind.

- ChatGPT verdeutlicht, wie auf Knopfdruck, durch Wechsel des KI-Modells von einem Moment auf den anderen ein wesentlich leistungsfähigerer KI-Chatbot entsteht: Durch Aktivierung des multimodalen KI-Modells GPT 4o, das im Gegensatz zu seinen Vorläufern nicht nur Text, sondern auch Bilder generieren und sogar Emotionen deuten kann.

- Interessant ist auch die in diesem CAIR4-Beitrag beschriebene Technik des „Model-Mergers“. Damit gemeint sind KI-Modelle, die sich quasi selbst erschaffen bzw. kontinuierlich weiterentwickeln können. Ohne dass man noch genau wüßte, welche Grenzen die einzelnen KI-Modelle besitzen.

- Nicht zu unterschätzen ist auch die Herausforderung im Fall von „sich selbst konsumierenden“ generativen KI-Modellen. Dieses Phänomen erschwert u.a. die regulatorische Abgrenzung generativer KI-Modelle zu KI-Systemen, denn das KI-Modell agiert mutmaßlich autonom, wenn es eigene (virtuelle) Outputs als (virtuelle) Input nutzt, dabei aber der intendierte Zweck nicht erkennbar ist.

Das letzte Beispiel erinnert an das juristische „Insichgeschäft“ i.S.v. § 181 BGB: Dabei schließt die gleiche Person mit sich selbst im Rahmen verschiedener rechtlicher Rollen ein Geschäft ab (z.B. der Geschäftsführer einer GmbH mit sich selbst als Privatperson).

2.1 Mehrzahl hat spezifische Zwecke

Kurzum: KI-Modelle sind hoch dynamische „Produkte“! Und die Mehrzahl von ihnen verfügt nicht über einen „allgemeinen“, sondern über einen „spezifischen“ Verwendungszweck. Das gilt u.a. für die Medizin, die Finanzwirtschaft oder im Rahmen kritischer Infrastrukturen. Mitunter wachsen KI-Modelle erst im Laufe der Zeit in einen Entwicklungsstand hinein, der eine Verwendung für „multiple Zwecke“ ermöglicht.

Es geht hier aber weniger um die Frage, wann aus irgendeinem „sonstigen“ KI-Modell ein KI-Modell „mit allgemeinem Verwendungszweck“ i.S.v. Artikel 3 Nr. 63 EU AI Act werden könnte. Es geht um die viel grundlegendere Frage, was überhaupt als KI-Modell i.S.d. EU AI Acts anzusehen ist und was nicht!

Das Ganze lässt sich mit einem „Modell-Baum“ darstellen, an dem sich verschiedene „Modell-Äpfel“ befinden. Mit den Äpfeln gemeint sind unterschiedliche Nennungen des Begriffs KI-Modell in der KI-Verordnung. Davon gibt es einige, die in Teil 2 dieses Beitrags präzisiert werden.

2.2 Abgrenzung von KI-Modell und Daten

Die Notwendigkeit klarer Kriterien gilt umso mehr, weil u.a. Artikel 3 Nr. 63 EU AI Act und Artikel 15 (5) S.3 EU AI Act) im Kontext von KI-Modellen auch Daten mit ins Spiel bringen: Wann und wie sind diese vom KI-Model zu trennen? Wann gelten sie als Teil eines KI-Models i.S.d. EU AI Act?

- Um regulatorische Aufwände abschätzen zu können sind Investoren und Entwickler bereits in der Design- und Entwicklungsphase auf klare Basiskriterien für KI-Modelle aller Art angewiesen. Nachträglich ist eine bereits bestehende Gesamtarchitektur nur noch schwer zu verändern bzw. an regulatorische Vorgaben anzupassen.

- Das gilt umso mehr, weil sich auch die regulatorischen Vorgaben dynamisch weiterentwickeln – Vorgaben, die nicht nur das KI-Modell, sondern mit z.T. fließendem Übergang auch den Datenschutz und andere Rechtsbereiche wie die Cyber-Security betreffen.

- Im Fall der Medizin oder der Finanzwirtschaft wird das Ganze noch von zusätzlichen regulatorischen Anforderungen flankiert, aufgrund derer ggf. geklärt werden muss, ob ein potenzieller Fehler im KI-Modell, den Trainingsdaten und/oder den Inputdaten liegt. Eine Definition bzw. ein Strukturmodell für KI-Modelle aller Art sollte das berücksichtigen.

3. Relevanz klarer Definitionen

Wie wichtig möglichst präzise regulatorische Definitionen aus Sicht von KI-Forschung und KI-Praxis sind, verdeutlicht eine aktuelles Dokument:

- Gemeint ist die wissenschaftliche Veröffentlichung von Dubey, Akshat, Zewen Yang, and Georges Hattab: „A Nested Model for AI Design and Validation.“ iScience (2024)

- Autoren sind Akshat Dubey, Dr. Zewen Yang und Dr. Georges Hattab vom Center of Artificial Intelligence in Public Health Research des Robert Koch Institutes (ZKI-PH).

- https://doi.org/10.1016/j.isci.2024.110603

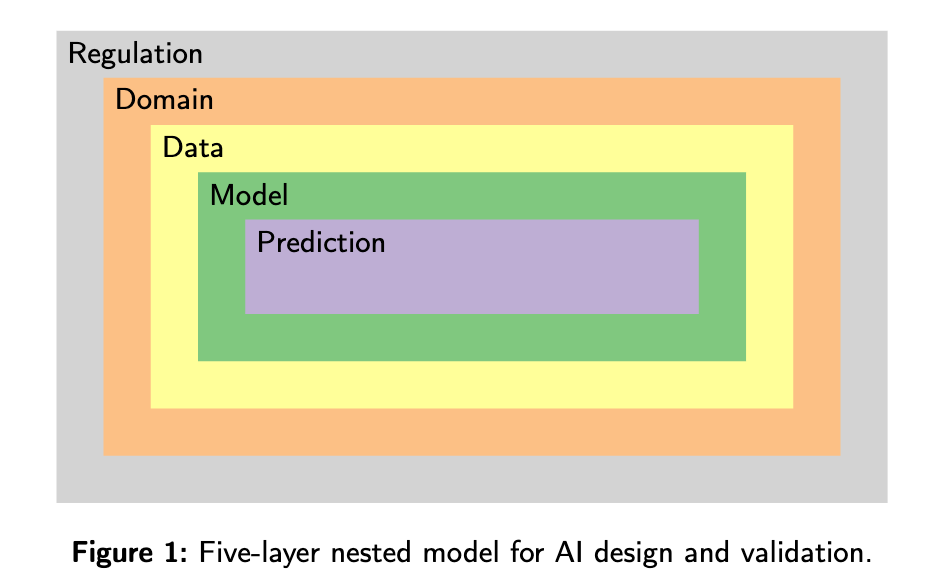

Das darin vorgestellte „5-Layer-Modell“ zum Design und der Validierung von KI differenziert die Aspekte:

- „Regulierung“,

- „Domain“,

- „Data“,

- „Model“ und

- „Prediction“.

3.1 Terminologische Klarheit

Aus Sicht der Autoren ist terminologische Klarheit unabdingbar, um vertrauenswürdige (trustworthy) und erst recht erklärbare (explainable) KI in praxi umsetzen zu können. Dabei spielt die Abgrenzug von KI-Modellen und verschiedener Formen von Daten eine durchaus wichtige Rolle. Gleiches gilt für die Frage, welche Elemente innerhalb des KI-Modells über die so genannte „Prediction“ entscheiden bzw. es ermöglichen, Entscheidungen des KI-Modells transparent und nachvollziehbar zu machen.

Das 5-Layer-Modell ist in mehrfacher Hinsicht gut gelungen:

- Man kann seine Logik schnell und leicht verstehen. Die anschauliche Grafik und klare Terminologien helfen beim Sortieren aller Arten relevanter Information.

- Dies hilft sowohl Entwicklern als auch Auftraggebern und Aufsichtsbehörden dabei, Vorgaben zu erfassen, Fehlerquellen einer KI zu finden, zu eliminieren und dadurch vertrauenswürdiger und möglichst rechtssicher zu gestalten.

- Wie genau mit dem 5-Layer-Modell umzugehen ist, wird im Paper anhand verschiedener Use Cases exemplarisch konkretisiert. Dabei werden durch variable Befüllung der Layer selbst komplexere Herausforderungen gut verständlich vermittelt.

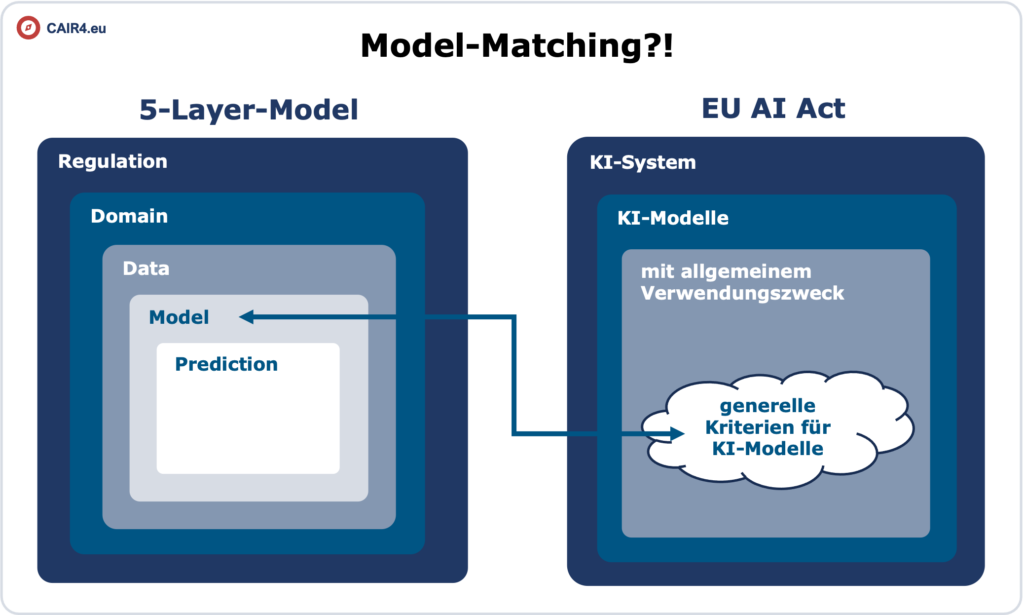

3.2 Matching mit KI-Modell i.S.d. EU AI Acts?

Trotzdem oder gerade deshalb stellt sich (auch) beim 5-Layer-Modell die Frage, in wieweit es systematisch und terminologisch mit den vorhandenen (und fehlenden) Definitionen des EU AI Acts harmoniert bzw. ob und wie sich beide Ansätze ergänzen können. Dabei spielt die Tatsache eine Rolle, dass das 5-Layer-Modell aus dem Bereich medizinischer KI stammt. Die wiederum ist in vielen Fällen aufgrund von Regel 11 als medizinische Software der Risikoklasse MDR IIa und damit als Hochrisiko-KI i.S.v. Artikel 6 (2) i.V.m. Anhang I/III EU AI Act zu klassifizieren – sie muss daher die KI-Modell-Vorgaben von Artikel 15 (5) EU AI Act beachten!

Dies führt zu spannenden Fragen: Kann das 5-Layer-Modell auch auf ein KI-Model mit allgemeinem Verwendungszweck (mit und ohne) systemische Risiken angewendet werden? Wie ist es im Fall einer medizinischen Hochrisiko-KI? Was ist mit sonstigen KI-Modellen?

Umgekehrt gefragt: Was bietet der EU AI Act selbst an, um die Herausforderungen der Praxis in dieser Hinsicht zu beantworten? Die KI-Verordnung bietet zumindest eines nicht: Eine übergreifend klare Definition für KI-Modelle! Gemeint ist eine Definition, die im Sinne des 5-Layer-Modells mit hoher Wahrscheinlichkeit dem grün markierten vierten Layer und den darin enthaltenen Sub-Layern zuzuordnen wäre bzw. diesen konkretisiert und von anderen Layern möglichst trennscharf abgrenzt.

3.3 Kooperation von Juristen u. KI-Experten

Wer ist nun in der Pflicht, entsprechende Aufgaben zu lösen? Sind es die Juristen, die allzu oft wichtige operative Detailfragen offenlassen? Sind es die KI-Experten, die sich gerne auf eine Fachsprache fokussieren, die außer ihnen niemand versteht?

So oder so: Das Paper des Robert Koch Instituts ist als Angebot zum konstruktiven Dialog beider Seiten zu verstehen! Zu Beginn des Papers weisen die Autoren zu recht darauf hin, dass KI-Regulierung und KI-Research u.a. im Hinblick auf Definitionen und Terminologien nach wie vor kaum harmonieren – und dass sich dies (auf beiden Seiten) ändern muss.

Zitat (frei übersetzt):

- … Regulierungskonzepte sind für KI-Forscher notwendig, da diese Konzepte es ermöglichen, Risiko- und Sicherheitsbedenken in den von den USA und Europa vorgeschlagenen Vorschriften zu berücksichtigen und zu verstehen.

- … die Bereiche der Regulierungswissenschaft und der KI divergieren und es sind keine größeren Überschneidungen in Sicht.

- … Wenn es um die Regulierung von KI geht, schreiten viele Regulierungsbehörden ein und machen die Einhaltung von Gesetzen zur Pflicht, die Erklärungen oder Interpretationen für die Nutzer verlangen, wenn sie mit algorithmischen Ergebnissen konfrontiert werden.

In anderen Worten: Es ist mehr Miteinander und gemeinsames Verständnis erforderlich – speziell dann, wenn regulatorische Fragestellungen so spezifisch werden, dass Techniker genau wissen müssen, was in welchen Bereichen ihrer Arbeit rechtlich, ethisch und/oder technisch von ihnen verlangt wird! Unbestimmte Rechtsbegriffe und fehlende Definitionen für Kernkomponenten einer KI erschweren dies erheblich!

3.4 Iterative Konkretisierung

Und so schließt sich der Kreis zum Thema KI-Modelle:

- KI-Modelle sind nicht „irgendein“ Bestandteil von KI-Systemen! Sie sind ihr Herz – und zwar eines, dass sich im Hinblick auf die Evaluation und Behandlung von „Herzrythmusstörungen“ von anderen „inneren Organen“ einer KI klar abgrenzen lassen muss.

- Diese Klarheit gilt es möglichst schnell zu ermöglichen, damit der EU AI Act nicht aufgrund seiner diesbezüglichen Unbestimmtheit zur Investitionsfalle und Innovationsbremse wird!

- Ein iteratives, konstruktiv-interdisziplinäres Miteinander scheint im Hinblick auf die fehlende Definition für KI-Modelle i.S.d. EU AI Acts nicht nur möglich, sondern auch dringend notwendig: Für Juristen ebenso wie für Daten-, KI- und Domain-Experten sowie viele weitere Stakeholder.

Vor diesem Hintergrund wird nachfolgend versucht, eine Brücke

- zwischen den existierenden Nennungen und Anforderungen zu KI-Modellen des EU AI Acts

- und dem 5-Layer-Modell der anwendungsbezogenen KI-Forschung zu bauen.

Um das Ergebnis vorwegzunehmen: Das 5-Layer-Modell kann nach der hier vertretenen Auffassung wertvolle Hilfe leisten, um die Lücke der fehlenden Definition für KI-Modelle iS.d. EU AI Act möglichst praxisgerecht zu füllen. Wie genau, wird nachfolgend ausgeführt.

Es wird empfohlen, das zitierte Paper des Robert Koch Instituts im Original zu lesen. Das 5-Layer-Modell funktioniert selbst für die Königsklasse der „explainable“ AI (XAI). Es scheint somit nach dem juristischen Grundsatz „a maiore ad minus“ auch für einfache KI-Modelle gut geeignet und damit als ideale Basis, um einen wichtigen Teil des Definitionsvakuums zumindest im Ansatz zu füllen!

3.5 Methodischer Ansatz

Um dem Inhalt einer generellen Definition für KI-Modelle näher zu kommen, werden im folgenden mehrere Wege beschritten, die im juristischen Sinne (zumindest im Bau- und Planungsrecht) als „Gegenstrom-Prinzip“ wechselseitiger Beeinflussung bezeichnet werden.

Demnach ist aus dem 5-Layer-Modell in Richtung des EU AI Acts und umgekehrt aus dem EU AI Act in Richtung des 5-Layer-Modells nach gemeinsamen, aber auch nach unterschiedlichen Aspekten zu suchen, um in Folge ein integriertes Verständnis zu skizzieren, das beide Welten bestmöglich verbindet.

Das 5-Layer-Modell erscheint als taugliches Instrument, um die Frage „Was ist ein KI-Modell i.S.d. EU AI Acts“ beantworten zu können. Dazu müssen aber im Wege des „Gegenstromprinzips“ Kriterien für ein terminologische Matching bestimmt werden.

Der Matchingprozess besteht aus mehreren Schritten:

1. Zu allererst werden existierende Definitionen für KI-Modelle geprüft (nachfolgend Teil 1).

2. Dann werden die Fundstellen im EU AI Act aufgelistet (Teil 2 des Beitrags).

3. Diese werden mit dem 5-Layer-Modell und den anderen Definitionen verglichen (Teil 2 des Beitrags)

4. Schließlich wird noch das Zusammenspiel von KI-Modell und KI-System beleuchtet (Teil 3 des Beitrags).

3.6 Bestehende Definitionen

Nachfolgend werden drei Varianten international gängiger Defitionen für KI-Modelle vorgestellt und im Hinblick auf ihre Passform für den EU AI Act untersucht:

- zwei Definitionen aus dem im internationalen KI-Business (IBM und HP),

- eine Erläuterung von KI-Modellen in YouTube,

- und die bestehende Definition der OECD.

3.6.1 Definitionen aus dem KI-Business

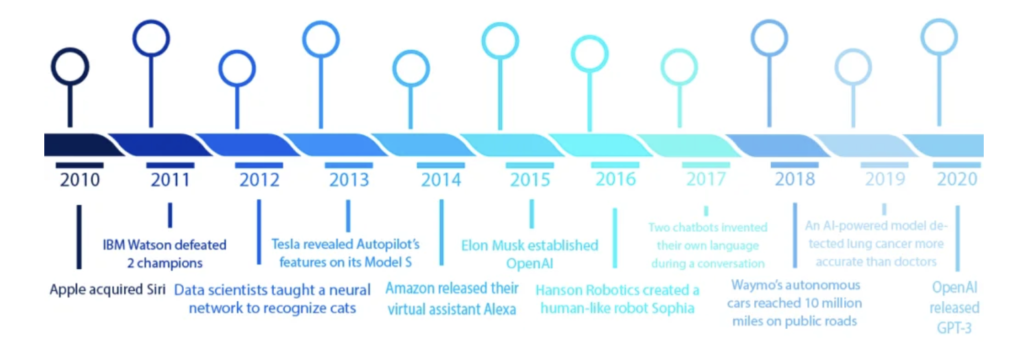

Relevant erscheint zunächst, was erfahrene Global Business Player wie IBM und HP zum Thema „AI Model“ zu sagen haben – ihre Definitionen gab es z.T. schon lange vor dem EU AI Act. Die nachfolgende Übersicht der KI-Evolution zeigt ganz gut, dass Services wie IBM Watson maßgeblich dazu beitragen haben, das Wesen und das Verständnis heutiger KI-Modelle zu prägen.

IBM schreibt zum Thema AI Model (englische Version, Stand August 2024):

- An AI model is a program that has been trained on a set of data to recognize certain patterns or make certain decisions without further human intervention.

- Simply put, an AI model is defined by its ability to autonomously make decisions or predictions, rather than simulate human intelligence.

- In simple terms, an AI model is used to make predictions or decisions and an algorithm is the logic by which that AI model operates.

HP schreibt zum Thema AI Model (Deutsche Version, Stand August 2024):

- KI-Modelle oder Modelle für künstliche Intelligenz sind Programme, die anhand einer Sammlung von Datensätzen bestimmte Muster erkennen.

- Es ist die Darstellung eines Systems, das Dateneingaben erhalten und Schlussfolgerungen ziehen bzw. basierend auf diesen Schlussfolgerungen agieren kann.

Beide Definition sind absolut berechtigt! Sie haben aber aus regulatorischer Sicht einen nicht zu unterschätzenden Haken: Durch die Verwendung von Begriffen wie „Programm“ oder „autonome Entscheidung“ oder „agieren“ ähneln sie stark der Definition von KI-Systemen i.S.v. Artikel 3 Nr. 1 EU AI Act. Insofern helfen sie nur bedingt weiter, denn gesucht wird eine Definition, die nicht nur erklärt, was ein KI-Modell i.S.d. EU AI Acts ist, sondern auch eine Definition, die trennscharf gegenüber KI-Systemen i.S.d. EU AI Acts ist.

3.6.2 YouTube Erkläuterung von KI-Modellen

Spannend ist, dass es insbesondere in YouTube eine Reihe von recht plakativen Erklärfilmen zu KI gibt, die neben Worten auch Grafiken und Animationen verwenden, um die Dynamik von KI-Modellen im Kontext von dessen Life Cycle zu verdeutlichen.

Eines von mehreren Beispielen dafür ist ein Video des Kanals „The CISO-Perspective“ – also der Perspektive von IT-Sicherheitsbeauftragten. Letztere ist ein Thema, das auch im Kontext des EU AI Acts sowie dem Cyber Resilience Act (CRA) eine wichtige Rolle spielt. Beide Normen sind u.a. im Kontext von Hochrisiko-KI-Systemen via Artikel 8 CRA und Artikel 15 EU AI Act miteinander verwoben – letztere Norm bildet mit Absatz 6 S.3 wiederum die Brücke zu KI-Modellen.

In dem folgenden Video wird ein KI-Modell ganz allgemein mit folgender – vergleichsweise einfacher – Gleichung umschrieben:

KI-Modell = Training (Algorithmen + Daten)

Der Vorteil dieser Definition ist: Sie ist „kurz und knackig“! Und ihr Nachteil ist: Sie ist „kurz und knackig“ – schlicht zu kurz, um im regulatorischen Sinne die Vielfalt und Herausforderungen von KI-Modellen greifen zu können.

Gleichwohl können und sollten plakative Videos inklusive der grafischen Elemente als Stilmittel dienen, um im operativen Sinne mehr Transparenz zu ermöglichen. Anders formuliert: (Gesetzes-)Text eallein helfen bei der Lösung ebenso abstrakter wie komplexer (regulatorischer) Herausforderungen nur selten weiter. Viele Juristen tun sich aber schwer, regulatorische Vorgaben zu visualisieren – das gilt nicht zuletzt auch für viele EU Guidelines, die im Zweifel nur noch mehr Text erzeugen, selbst wenn dieser wie im Fall vieler Leitlinien ansprechender gestaltet ist als bloßer Gesetzestext.

Ein Beispiel, das bereits in eine etwas plakativere Richtung geht, sind die verschiedenen Guidelines der EU zur Medical Device Regulation (MDR). Doch in Bezug auf KI-Leitlinien sollten noch deutlich mehr grafische Übersichten und ggf. auch Animationen integriert werden, um das komplexe Zusammenspiel verschiedener Einzelelemente wie „KI-System“ und „KI-Modell“ im wahrsten Sinne des Wortes zu „versinnbildlichen“.

Die EU kann und sollte im Hinblick auf die Konkretisierung des EU AI Acts in Leitlinien mutig entsprechende Wege gehen! Das im zweiten Teil näher beleuchtete 5-Layer-Modell zeigt, wie entsprechende Ansätze aussehen könnten. Selbst wenn diese innerhalb des eigentlichen Leitlinien-Textes statisch sind, so können sie doch zusätzlich durch Animationen (wie die beim hier vorgestellten Video) anschaulich erweitert werden.

3.6.3 Ansatz der OECD

Der letzte Punkt führt wie von selbst zur OECD: Diese hat im März 2024 (also nahezu zeitgleich mit der finalen Version der KI-Verordnung) ein Grundsatzpapier zu eben diesem Thema veröffentlicht. Darin wird klar zwischen KI-Systemen und KI-Modellen unterschieden. Mindestens ebenso wichtig: Es gibt für beide Begriffe nicht nur Definitionen, sondern auch übergreifende Schaubilder (wenngleich in eher geringem Umfang).

Besonders wichtig ist, dass die OECD-Definition von KI-Systemen die der KI-Verordnung erheblich beeinflusst hat!

Zum Vergleich: Die beiden Definitionen für KI-Systeme (Stand März 2024)

Definition der OECD (en):

An AI system is a machine-based system that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments. Different AI systems vary in their levels of autonomy and adaptiveness after deployment.

Definition EU AI Act (en)

AI system’ means a machine-based system designed to operate with varying levels of autonomy, that may exhibit adaptiveness after deployment and that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments

3.6.3.1 Zusammenspiel von KI-System und KI-Modell

Wie gesagt: Die OECD hält nicht nur eine Definition für KI-Systeme parat. Das Dokument vom März 2024 enthält auch eine Definition für KI-Modelle. Dabei weist die OECD bewußt darauf hin, dass es diesbezüglich eine Vielzahl uneinheitlicher Vorstellungen gibt. Vielleicht hat die OECD genau aus diesem Grund ihre zuvor existierende Definition für KI-Modelle (siehe u.a. OECD-Dokument von 2022 ) noch einmal modifiziert.

Hier das finale Ergebnis (frei übersetzt):

„Ein KI-Modell ist eine physikalische, mathematische oder anderweitig logische Darstellung eines Systems, einer Entität, eines Phänomens, eines Prozesses oder von Daten entsprechend der Norm ISO/IEC 22989.

Zu den KI-Modellen gehören u. a.

- statistische Modelle und verschiedene Arten von Input-Output-Funktionen (wie Entscheidungsbäume und neuronale Netze).

- Ein KI-Modell kann die Übergangsdynamik der Umgebung darstellen und ermöglicht es einem KI-System, Aktionen auszuwählen, indem es indem es ihre möglichen Konsequenzen anhand des Modells untersucht.

- KI-Modelle können manuell von menschlichen Programmierern erstellt werden oder

automatisch erstellt werden, z. B. durch unüberwachte, überwachte oder verstärkende maschinelle Lernverfahren.„

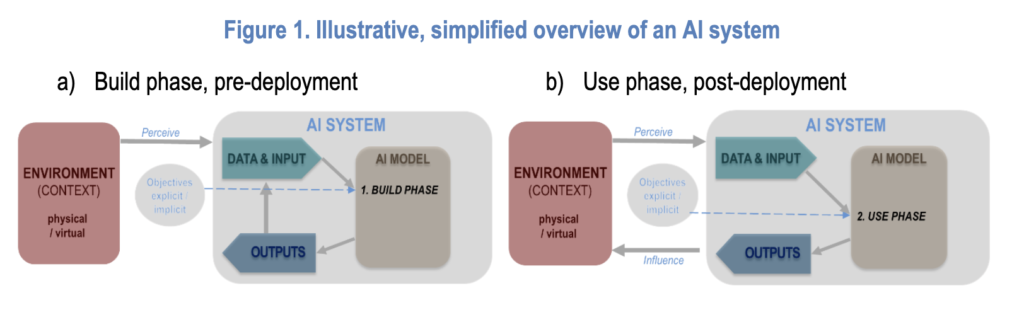

Das Zusammenspiel beider Definitionen der OECD existiert also nicht erst seit 2024! Bereits 2022 wurden die Begriffe „KI-System“, „Mensch und Umwelt“, „ökonomischer Kontext“, „Daten und Input“ sowie „KI-Modell“ als auch „Aufgaben und Output“ explizit definiert – danach allerdings auch immer wieder ein wenig modifiziert.

Stand 2024 sieht das Zusammenspiel von KI-System und KI-Modell laut OECD wie folgt aus:

Eigentlich hätte die EU das zuvor skizzierte „Kombi-Modell“ der OECD übernehmen können – hat sie aber nicht! Daher muss die EU an irgendeinem imaginären Punkt die Entscheidung getroffen haben:

- eine an die OECD angelehnte Definition für KI-Systeme in den EU AI Act zu integrieren,

- und darüber hinaus die damit abgestimmte Definition der OECD für KI-Modelle wegzulassen.

3.6.3.2 Keine Berücksichtigung in EU AI Act

Um es noch einmal mit anderen Worten zu betonen:

- Es gab und gibt seitens der OECD sowohl eine Definition für KI-Systeme als auch für KI-Modelle – und das bereits seit 2022.

- Einerseits wurde die Definition der OECD für KI-Systeme im EU AI Act weitgehend übernommen.

- Andererseits wurde die darauf abgestimmte Definition für KI-Modelle nicht einmal angedeutet: Es gibt daher Stand heute gar keine übergreifende Definition für KI-Modelle im EU AI Act!

Aufgrund ihrer Orientierung an der OECD müssen die Gestalter der KI-Verordnung auf die Frage gestoßen sein, ob sie zusätzlich zur Definition von KI-Systemen auch eine Definition für KI-Modelle in den EU AI Act aufnehmen sollte bzw. welche – z.B. als zusätzliche Nr. 69 von Artikel 3 EU AI Act (dieser Artikel enthält ja auch alle anderen „wichtigen“ Definitionen). Das ist nicht passiert! Das Weglassen einer Definition für KI-Modelle wird aber weder erwähnt noch begründet.

3.6.4 Chance zur Konkretisierung von KI-Modell i.S.d. EU AI Acts

Im Hinblick auf die Frage, warum dies nicht erfolgt ist, kann man nur spekulieren. Die Begründung des EU AI Acts lieftert dazu keine Hinweise. Auch in den Medien ist dazu bislang nicht viel zu finden. Insofern stellt sich eine durchaus interessante Frage:

Könnte es ein Vorteil sein, dass die Definition von KI-Modellen im EU AI Act fehlt?

Es gibt verschiedene Gründe, die dafür sprechen, dass es (zumindest im Moment) noch kein Nachteil ist:

- Zunächst kann man vortrefflich darüber streiten, ob und wie weit die Definition der OECD von KI-Modellen besser oder schlechter ist als die davor genannten Definitionen aus dem Business. Die letzte Version von 2024 fällt nicht weniger kryptisch aus als die ohnehin schwer eingängige Definition für KI-Systeme. Hätte ihre Verwendung im EU AI Act zu mehr Klarheit geführt? Man darf dies anzweifeln.

- Es kann folglich nicht ausgeschlossen werden, dass die EU ganz bewußt nur die Definition für KI-Systemen von der OECD übernommen hat. Entweder sie hat die Definition für die sich rasant weiterentwickelnden KI-Modelle vergessen oder bewußt weggelassen hat bzw. heimlich „unter den Tisch“ fallen lassen.

- In Anbetracht der geringen Zeit vor Verabschiedung des EU AI Acts und der vielen strittigen Details rund um KI-Modelle mit allgemeinem Verwendungszweck ist es vorstellbar, dass der Verzicht als Chance im Hinblick auf flexible und zeitgerechte Auslegung angesehen wurde – in dem KI-Modelle primär in Leitlinien konkretisiert werden. Nicht im eigentlichen Gesetzestext.

Hätte die EU das diesbezügliche Ziel gehabt, hätte man es allerdings auch in den Erwägungsgründen oder sogar als Task für die Zukunft in einem Artikel hervorheben können (z.B. in Artikel 56 EU AI Act). Das ist nicht der Fall. Gleichwohl besteht nach wie vor die Chance, das Thema im Rahmen der Leitlinienerstellung, besser noch bei der Erstellung des Code of Practice aufzugreifen!

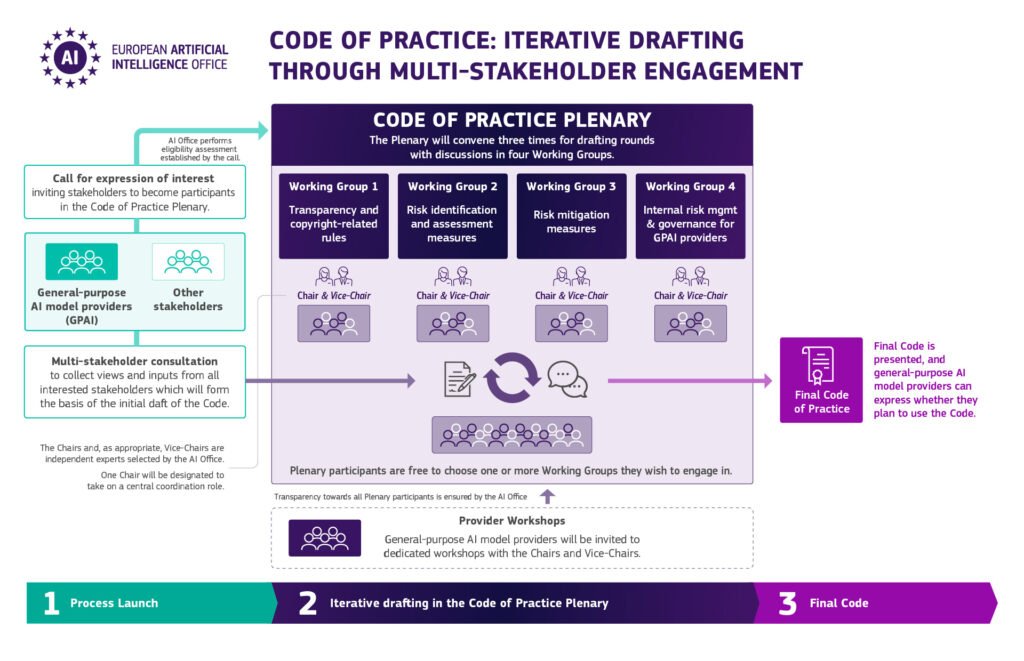

3.7 Die große Chance: Die Entwicklung des Code of Practice für GPAI-Modelle

Die vielleicht wichtigste Chance, um KI-Modelle übergreifend zu präzisieren, stellt in diesem Zusammenhang die Pflicht des European AI Office dar, die in Artikel 56 (9) EU AI Act vorgeschriebenen Praxisleitfäden für GPAI-Modelle bis spätesten 2. Mai 2025 zu entwickeln.

Details zu diesem partizipativ gestalteten Prozess findet man hier.

Der Code of Practice kann und sollte nicht nur Leitlinien für GPAI-Modelle zum Ziel haben. Er sollte auch (zeitbezogene) Basiskriterien für KI-Modelle aller Art festlegen! Erst dadurch entsteht die notwendige Klarheit, wann und wie weit im Einzelfall das Terrain der GPAI-Modelle betreten wird.

Zudem können die Kriterien für Open-Source-Modelle, deren Modifikation und das Zusammenspiel mehrerer KI-Modelle konkretisiert werden. Relevant wäre auch die Klärung, wie zu verfahren ist, wenn ein oder mehrere (GPAI-)Modelle in einer Hochrisiko-KI eingesetzt werden. Dann sind nicht nur die Vorgaben für GPAI-Modelle zu beachten. Wichtig sind dann auch die Anforderungen von Artikel 15 (5) EU AI Act.

Von Vorteil ist sind entsprechend übergreifend gültige Krieren für KI-Modelle aus vielen Gründen. Zum Beispiel, wenn sich ein „single-purpose“ KI-Modell im Laufe der Zeit zu einem GPAI-Modell weiterentwickelt – oder genau das verhindert werden soll.

3.8. Zwischenfazit und Ausblick auf Teil 2

Zunächst wurde aufgezeigt, dass insbesondere im Bereich von KI-Forschung Bedarf an übergreifend klaren Definitionen und der Annäherung von Regulatorik und operativer KI-Praxis besteht. Das gilt auch im Hinblick auf KI-Modelle. Mit dem 5-Layer-Modell ist auch ein interessantes Instrument vorhanden, um Brücken zwischen KI-Forschung und bestehenden Vorgaben des EU AI Acts zu bauen. Dies nicht zuletzt deshalb, weil das 5-Layer-Modell bewußt grafische Elemente nutzt – und nicht nur auf Text beruht. So können Herausforderungen für alle Beteiligten gut veranschaulicht und darauf basierend bestmöglich gelöst werden.

Bevor diese Brücke im weiteren skizziert wird, wurde geprüft, inwieweit die bestehenden Definitionen von KI-Modellen aus dem KI-Business und der OECD die Lücke schließen könnten. Doch weder die Definitionsansätze der Wirtschaft noch die Definition der OECD scheinen im Hinblick auf die spezifischen Kriterien für KI-Modelle i.S.d. EU AI Acts weiterzuhelfen. Empfohlen wird jedoch, den von der OECD bereits in einfacher Form beschrittenen Weg der Visualisierung von Definitionen weiter auszubauen – im Idealfall auch zu animieren.

Vor diesem Hintergrund ist nach der hier vertretenen Auffassung ist das Fehlen einer übergreifenden Definition für KI-Modelle im EU AI Act Chance und Risiko zugleich:

3.8.1 Die Chancen: Leitlinien!

- Leitlinien eignen sich viel besser, um ein hoch dynamische Feld wie das der KI-Modelle zu präzisieren als vergleichsweise statische juristische Normen. Sie können und sollten auch Grafiken enthalten.

- Zudem steht die Entwicklung des Code of Practice von GPAI-Modellen aktuell bevor – es wäre einerseits genug Zeit vorhanden. Andererseits ist die Wartezeit bis Mai 2025 auch nicht zu lang.

- Der Prozess der EU sieht auch die Mitwirkung von „other stakeholders“ vor: Das sind nach der hier vertretenen Auffassung insbesondere die Anbieter von allerlei „sonstigen“ KI-Modellen, die großes Interesse besitzen dürften, nicht versehentlich unter die Vorgaben von Kapitel V zu fallen.

- Systematisch scheint es auch sehr gut möglich, die Klärung der Grundfrage „Was ist ein KI-Modell i.S.d. EU AI Acts“ in jede der vier Arbeitsgruppen mit einfließen zu lassen.

3.8.2 Das Risiko: Nichts passiert!

- Würde beim Erstellen des Code of Practice für GPAI-Modelle keine übergreifende Konkretisierung für KI-Modelle aller Art integriert, würde das Problem erst einmal für längere Zeit so weiter bestehen wie bisher.

- Dann würde dem EU AI Act weiterhin ein wichtiger Baustein fehlen, um die dringend benötigte Rechtssicherheit zu fördern bzw. um KI-Forschung und KI-Praxis bestmöglich zu unterstützen, damit das Fehlen der Defintion nicht zur Innovationsbremse wird.

3.8.3 Ausblick auf den zweiten Teil

Da das Ergreifen der Chancen nicht nur möglich, sondern auch sinnvoll erscheint, wird nachfolgend von dem Szenario ausgegangen, dass die interdisziplinäre Erarbeitung des Code of Practice das Thema „Kriterien für KI-Modelle“ proaktiv aufgreifen wird.

Dem soll im weiteren zugearbeitet werden:

- Ein Schwerpunkt des zweiten Teils wird die Auflistung von Fundstellen sein, welche im Text des EU AI Acts KI-Modelle egal welcher Art erwähnen. Aus den Erwähnungen werden anschließend Kriterien extrahiert, denen mutmaßlich alle Arten eines KI-Modell i.S.d. EU AI Acts gerecht werden müssen.

- Darauf aufbauend wird das 5-Layer-Modell dahingehend analysiert, wie es die zuvor evaluierten Kritierien des EU AI Acts sinnvoll integrieren bzw. weiterentwickeln könnte – u.a. im Hinblick auf das Zusammenspiel von KI-Modell und Daten oder auch die Ergänzung bzw. Erweiterung des 5-Layer-Modells um Kriterien wie den „allgemeinen Verwendungszweck“ oder „systemische Risiken“ eines KI-Modells mit allgemeinem Verwendungszweck.

- Im dritten Teil folgt schließlich eine Auseinandersetzung mit der Frage, wie das 5-Layer-Modell so verwendet werden kann, dass es regulatorische Vorgaben für KI-Systeme unterschiedlicher Risikoklassen als auch unterschiedlicher KI-Modelle i.S.d. EU AI Acts bestmöglich erfassen, abbilden und operativ steuern kann.

Link zu Teil 2 dieses Beitrags

Links zu den in diesem Artikel erwähnten Normen des EU AI Acts:

Über den Autor:

Schreibe den ersten Kommentar